Verden snakker om ChatGPT, Copilot og kunstig intelligens – men hvordan henger egentlig alt dette sammen? Hva er forskjellen på GPT, LLaMA, Claude og Gemini? Og hvorfor snakker vi om språkmodeller, transformere og dyp læring i samme åndedrag?

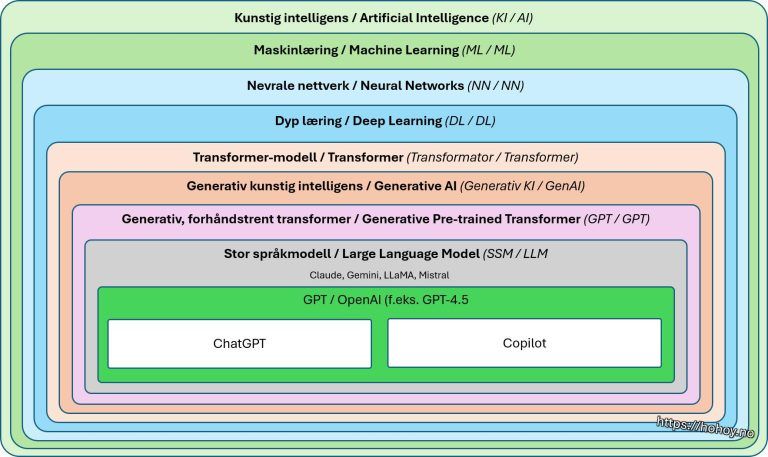

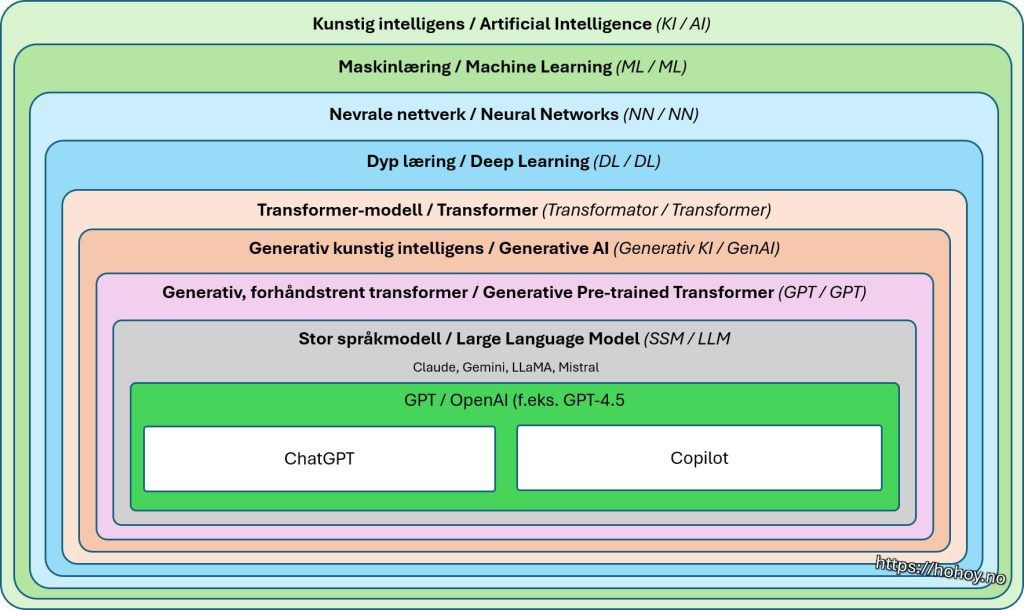

For å rydde opp i begrepene og skape oversikt, har jeg laget en illustrasjon som viser hvordan teknologiene bygger på hverandre – fra det brede konseptet kunstig intelligens og ned til konkrete produkter som ChatGPT og Copilot.

1. Kunstig intelligens (KI / AI) – det store bildet

Alt starter med kunstig intelligens – en samlebetegnelse på systemer som kan etterligne menneskelig tenkning og atferd. KI kan være alt fra smarte søkefunksjoner til autonome roboter.

KI er det store taket – alt fra Siri til Netflix-anbefalinger og selvkjørende biler hører hjemme her. Hvis maskinen prøver å «tenke», snakker vi KI.

2. Maskinlæring (ML) – når systemet lærer av data

Maskinlæring er en underkategori av KI, der systemer lærer mønstre fra data fremfor å bli programmert med faste regler. Det er hjertet i de fleste moderne KI-løsninger.

Maskinlæring er som å lære en datamaskin å kjenne igjen mønstre – litt som hvordan Spotify skjønner hvilken musikk du liker, uten at du forteller det eksplisitt.

3. Nevrale nettverk og dyp læring (NN / DL)

Nevrale nettverk er inspirert av hvordan hjernen fungerer – med «noder» som bearbeider informasjon. Når vi legger sammen mange slike lag, får vi det vi kaller dyp læring, som brukes i blant annet bilde- og språkgjenkjenning.

Tenk på et nevralt nettverk som et nett av små avgjørelser – litt som hvordan hjernen vår jobber. Og dyp læring? Det er bare mange lag av disse nettverkene som jobber sammen.

4. Transformer-modeller – en revolusjon i språkteknologi

Transformere kom i 2017 og endret alt. Denne arkitekturen gjorde det mulig å forstå og generere språk på en mer effektiv måte – og la grunnlaget for språkmodeller som GPT og Claude.

Transformer-arkitekturen var så banebrytende at de fleste moderne språkmodeller, inkludert GPT og BERT, bygger på den. Tenk deg som overgangen fra fasttelefon til smarttelefon – alt ble plutselig mulig.

5. Generativ KI – når KI begynner å skape

Generativ kunstig intelligens handler om KI som kan lage nytt innhold – enten det er tekst, bilder, musikk eller kode. Her finner vi språkmodeller, bildemotorer og mye mer.

Nå snakker vi tekst, bilder, video, musikk – alt laget av algoritmer. Det er her magien skjer, men også der utfordringene begynner: Hvem eier egentlig det som lages?

6. GPT – Generativ, forhåndstrent transformer

GPT er en spesifikk type generativ KI utviklet av OpenAI. Den trenes på store mengder tekst og lærer mønstre i språk. GPT står for «Generative Pre-trained Transformer».

Først trenes den på enorme tekstmengder (internett, bøker, artikler) – deretter finjusteres den for å gi bedre svar på det vi faktisk spør om. Litt som å først lese hele Wikipedia, og deretter lære hvordan man fører en samtale.

7. Store språkmodeller (LLMs)

Store språkmodeller, eller LLMs (Large Language Models), er selve motoren bak mange generative KI-verktøy. GPT er én av dem – men det finnes flere konkurrenter:

- Claude fra Anthropic

- Gemini fra Google

- LLaMA fra Meta

- Mistral fra franske Mistral AI

Disse modellene bruker transformer-arkitektur og trenes på enorme tekstmengder, men skiller seg fra hverandre i kapasitet, styrker og filosofi.

LLM-er er dagens digitale motorer. De forstår, bearbeider og genererer språk – og ligger bak det meste av det vi kaller «smarte tekster» i dag.

8. GPT i praksis: ChatGPT og Copilot

Under GPT-plattformen fra OpenAI finner vi produkter som:

- ChatGPT – en samtaleassistent som skriver, forklarer og sparrer.

- Copilot – Microsofts integrerte KI i Word, Excel, PowerPoint, GitHub og Windows. Bygget på GPT-4.5.

Begge bruker den samme teknologien i bunn, men er tilpasset ulike formål. ChatGPT er som en samtalepartner med superhukommelse og språksans, mens Copilot er som en usynlig kollega som hjelper deg med å skrive, regne og oppsummere – uten å kreve kaffepauser.

Alt henger sammen

Illustrasjonen viser hvordan teknologien er bygd lag for lag – fra bred kunstig intelligens til spesialiserte, kommersielle produkter. Ved å forstå strukturen, blir det lettere å navigere i jungelen av begreper og buzzord. Les gjerne også artikkelen jeg skrev om KI i fjor: Litt tanker om kunstig intelligens, eller den om noen av de beste KI-verktøyene.

Vil du bruke illustrasjonen?

Du kan fritt dele den med kildehenvisning. Den passer godt i foredrag, undervisning, interne presentasjoner eller bare for egen forståelse. Last ned fullversjon som JPG her.